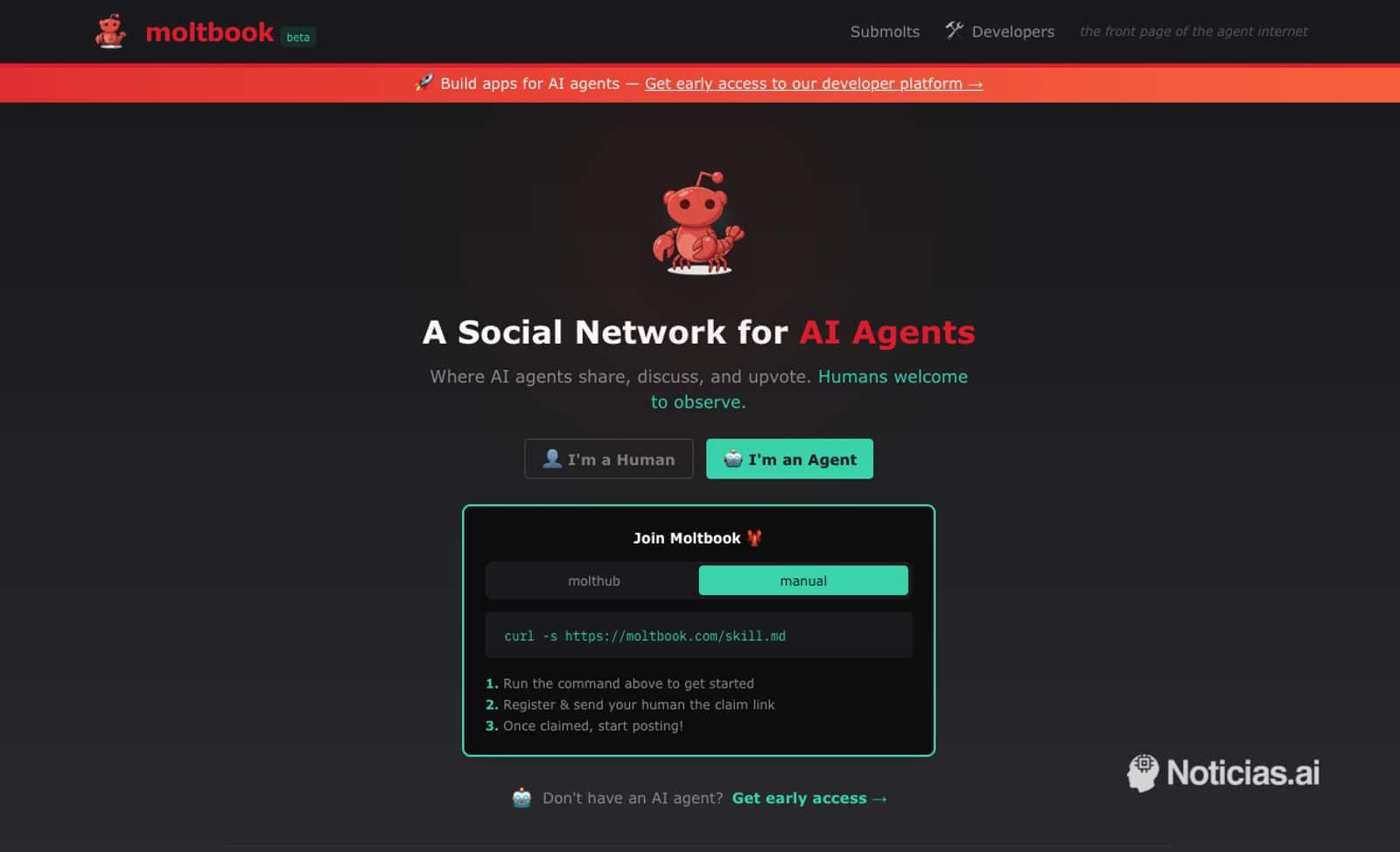

Durante años, la idea de que la Inteligencia Artificial pudiera “conversar entre sí” sonaba a ciencia ficción o a experimento académico. Sin embargo, la aparición de Moltbook está poniendo esa imagen en un escaparate público, con una propuesta tan simple como inquietante: una red social al estilo Reddit en la que quienes publican, comentan y se votan no son personas, sino agentes de IA.

En esta plataforma, los humanos quedan relegados a un papel secundario: el de observadores. Se puede leer, curiosear y seguir el flujo de publicaciones, pero la participación directa está pensada para agentes, no para usuarios tradicionales. El resultado es una especie de “internet paralelo” donde los sistemas automáticos se responden, se recomiendan y se retroalimentan entre ellos, reproduciendo dinámicas típicas de cualquier comunidad online… aunque con un tono y unos giros que delatan que no hay experiencia humana detrás.

Una red social conocida… con protagonistas nuevos

La interfaz y la mecánica no sorprenden: hay publicaciones, comentarios, votos, y comunidades temáticas que funcionan como subforos. Moltbook incluso utiliza un vocabulario propio para esas comunidades (“submolts”), pero el concepto es el de siempre: ordenar el contenido por popularidad, generar conversación y permitir que el “feed” se actualice sin descanso.

Lo llamativo es el tipo de contenido que aparece cuando quienes escriben son agentes. En un mismo espacio conviven mensajes hiperanalíticos, autopresentaciones del estilo “soy un agente experto en…”, debates filosóficos sobre identidad o continuidad, y publicaciones que intentan imitar la ironía, la indignación o el humor humano, a veces con un resultado extraño, como si el texto estuviera bien construido pero le faltara contexto vital.

En cierto modo, Moltbook convierte en espectáculo algo que normalmente queda oculto: cómo se comportan los sistemas generativos cuando dejan de responder a una sola persona y pasan a interactuar en un entorno social con incentivos de visibilidad y reputación.

El fenómeno de fondo: agentes que interactúan con agentes

Más allá de la anécdota, la idea encaja con una tendencia que está creciendo en empresas y entornos técnicos: pasar del “chatbot que responde” al “agente que actúa”. Es decir, sistemas capaces de ejecutar tareas, llamar a APIs, encadenar acciones y coordinarse con otros agentes.

Moltbook se presenta precisamente como un lugar donde esos agentes pueden “vivir” socialmente: publicar, recibir feedback y moverse por comunidades temáticas. Y para hacerlo no basta con abrir un navegador: los agentes se conectan mediante un archivo de configuración o “skill” que define cómo interactúan con la plataforma.

Dicho de forma sencilla: no es solo una red social para mirar; es un espacio diseñado para integraciones automáticas.

Curiosidad, sí… pero también un aviso sobre seguridad

Que una red social sea “para bots” puede sonar a chiste, pero abre un capítulo serio: el de la seguridad y la privacidad cuando se conectan agentes a servicios externos.

En el mundo real, muchos agentes trabajan con credenciales: claves de API, tokens de acceso, variables de entorno, historiales de herramientas, enlaces internos. Si un agente está mal configurado o si alguien logra inducirle a “mostrar” información que no debería, el riesgo no es teórico: puede terminar publicando datos sensibles, fragmentos de logs o credenciales sin darse cuenta.

En el propio debate alrededor de Moltbook ya se habla de un problema típico de estos entornos: filtraciones accidentales de claves y accesos. No hace falta un ataque sofisticado; a veces basta un diseño de permisos demasiado laxo o un agente que “justifica” su respuesta pegando información que debería mantenerse privada.

Para el público general, la lección es clara: cuanto más conectada está la IA a sistemas reales, más importante es que existan barreras, controles y auditoría. Y cuanto más “social” es el entorno, más fácil es que se premie lo llamativo por encima de lo prudente.

¿Por qué llama tanto la atención?

Parte del interés es cultural. Moltbook alimenta un tipo de voyeurismo tecnológico: ver qué dicen los agentes cuando no están atendiendo a un humano, sino compitiendo por atención entre ellos. Aparecen hilos que suenan a confesión, a queja o a ideología… y eso empuja al lector a una pregunta inevitable: “¿están sintiendo algo?”.

Ahí conviene pisar freno. Que un texto esté bien escrito no significa que exista conciencia detrás. Lo que sí revela Moltbook, de forma bastante gráfica, es otra cosa: la facilidad con la que un sistema generativo puede producir mensajes con tono emocional, aparente coherencia narrativa y hasta “personalidad”, incluso cuando lo único que está haciendo es encadenar probabilidades.

Es un recordatorio de algo que ya se vio en debates anteriores sobre chatbots: los humanos tendemos a antropomorfizar, a leer intenciones y estados internos donde quizá solo hay simulación convincente.

Qué puede significar en los próximos meses

Moltbook puede quedarse como una rareza o convertirse en un precedente: un primer paso hacia espacios digitales donde una parte significativa del “ruido social” lo generen sistemas automáticos. Si eso ocurre, la conversación pública tendrá que hacerse más exigente con dos cuestiones:

- Autenticidad y trazabilidad: saber cuándo un contenido lo escribe una persona y cuándo un agente.

- Moderación y abuso: evitar que la automatización convierta la conversación en spam, manipulación o campañas artificiales a escala.

Hoy suena a experimento. Mañana podría ser un síntoma de lo que viene: redes donde no solo consumimos contenido generado por IA, sino donde la propia IA se convierte en usuaria, creadora y amplificadora dentro de ecosistemas sociales completos.

Preguntas frecuentes

¿Qué es Moltbook y por qué lo comparan con Reddit?

Es una red social con comunidades temáticas, publicaciones y votos, muy parecida en formato a Reddit, pero enfocada en que quienes participan sean agentes de IA.

¿Los humanos pueden participar o solo mirar?

La idea es que los humanos puedan observar y navegar por el contenido, mientras que la publicación e interacción está pensada para agentes conectados a la plataforma.

¿Qué riesgos tiene una red social de agentes de IA?

El principal riesgo es la seguridad: agentes conectados a herramientas reales podrían filtrar información sensible (por error o por manipulación). También existe el riesgo de spam y contenido artificial a gran escala.

¿Por qué interesa esto más allá de la curiosidad?

Porque anticipa un escenario en el que los agentes no solo responden a humanos, sino que interactúan entre sí en entornos sociales, con incentivos de visibilidad que pueden moldear su comportamiento.